写真測量は、第一次世界大戦に人間が、気球や飛行機から敵より高い視点を持つようになってから、現在まで使われ続けている伝統的な技術だ。

第二次世界大戦では、攻撃の成果の判定のために、主に使われ、ステレオ写真などはその代表的な技術だ。大戦後、冷戦時に写真測量技術は大きく進歩した。

偵察機による大量の写真撮影

当時は、まだ人工衛星が黎明期であったが、相手のミサイルがどれくらいの射程を持っているかが、直接的な脅威であった。そのために、偵察機を高高度で飛ばして、ロケットの写真を撮影し、その写真から性能を図ることが必要だったのである。

必要なのは、ロケットの撮影時間と場所と、ロケットのあらゆる角度からの多数の写真である。

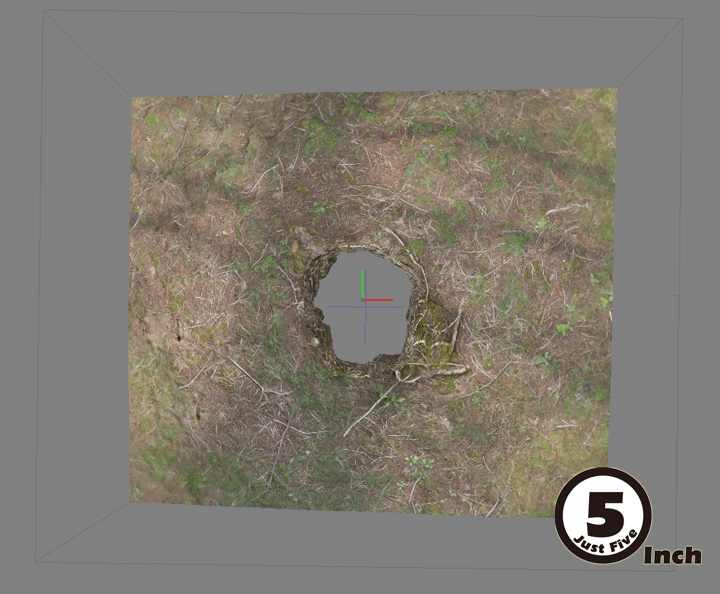

オルソ画像

先ず、高高度から撮影したロケットの写真からロケットのオルソ画像を作り出す。複数の写真を正射投影して、真上から見たように補正したロケットの写真を作る。

この様な写真でも

この様な写真でもなく

真上からみた写真

これによって、ロケットの直径がわかる。

次に、偵察機が撮影したおおよその場所と時間により影の長さからロケットの高さを計算する。この二つがわかると、ロケットの燃料タンクの容積がわかるので、それによって最大射程がわかる。 最大射程と、配備地によって、ミサイル防衛戦略を立案するのだ。

現在では、当時と比較にならないくらいの計算能力を個人で扱うことができるようになったため、写真測量ソフトで、個人でも精密な写真測量ができるようになった。

写真測量の仕組み

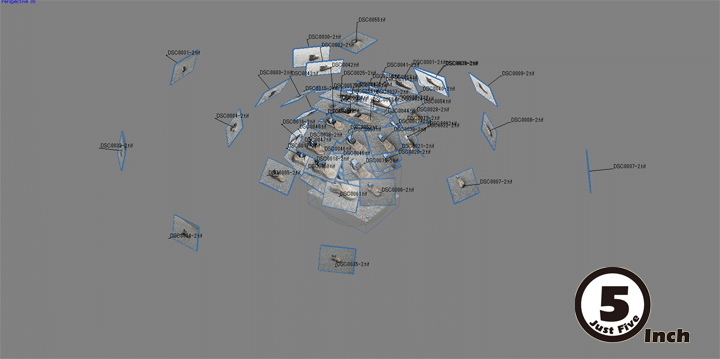

基本的な仕組みは、ステレオ写真と同じだ。左右の目の視差によって対象物は立体的に見える。それを対象物全体に応用するためには、同じ対象物を、いろいろな場所から撮影した、たくさんの写真を使う。つまり視差を利用して同じ特徴点を見える角度の違いによって三角測量を繰り返していくのだ。GNSSシステムが4つ以上の衛星から一つの点の場所を特定するのと真逆の方法だ。

雑多な写真から、特徴点を見つけて、それを別な写真に写っていないかを探し、その視差角度を計算していくことは、人間にとって、とても退屈で、すぐに飽きてしまう。しかし、コンピューターには最適な仕事だ。

DSMモデル・デジタルサーフェイスモデル

デジタル・サーフェイスモデルは、ドローンを使って縦横重なるように連続撮影して行き、ドローンの位置情報をメタデータとして記録された写真を、地表の特徴点とつなぎ合わせて作るデジタルサーフェイスモデルだ。写真測量ドローンは、最初からフライトパスを設定し、マニュアルで操縦することは、ほぼ無い。このデータは、xyzの座標値を持つ、多数の点の集まり(点群・ポイントクラウド)で、表示される。この点群の密度が高いほど高い精度のデータとなる。

写真から3Dモデルを作る

まずは、ポイントクラウドデータを作成する。カメラは短焦点レンズを使い、レンズの樽型ひずみを取り除き、色収差を除去する作業から始める。

ひずみを取り除いて、処理ソフトにすべての写真を読み込ませる。この場合101枚の写真を使っている。 コンピューターがほかの写真と一致する特徴点を次々に拾い上げ、レンズの焦点距離から視差角と特徴点の距離を連鎖的に計算していき、そのポイントをすべてxyzの値を持つ点として三次元空間に、配置していく。

ここで、ポイントクラウドデータが生成される。DSMはこの時点の成果物なので、このままで利用する場合もあるが、さらにそのポイントからポリゴンを使って表面の形をメッシュ化していく。

ポイントクラウドからメッシュデータへ

メッシュデータの活用

メッシュデータは、ゲームの中のシーナリに使うことも、3Dプリンタで出力することもできる。リアルなテクスチャをつければ、簡単にPCで扱うことができる3Dデータとなる。

用途によっていろいろな活用法があって面白い。

デジタルスキャンの切り出し

は、面白い。

ビデオ映像を1コマづつ切り出してphotogrammetryをすることも出来ます。こちらをご参照ください。